NVIDIA A100 - Genialna Technologia

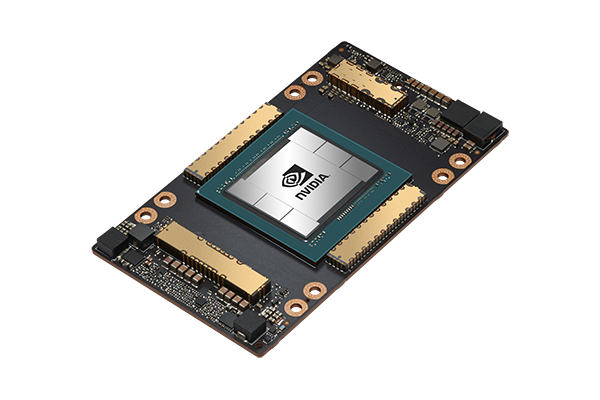

| NowościProcesor graficzny NVIDIA A100 został stworzony w celu dostarczenia jak największej mocy obliczeniowej w obszarze sztucznej inteligencji (AI) i obliczeń o wysokiej wydajności (HPC) dzięki nowej architekturze NVIDIA Ampere oraz optymalizacjom. Zbudowany w oparciu o technologię TSMC 7nm N7 FinFET, A100 cechuje się poprawioną gęstością tranzystorów, wydajnością i efektywnością energetyczną w porównaniu do wcześniejszej technologii 12nm. Dzięki nowym możliwościom Multi-Instance GPU (MIG) w GPU Ampere, A100 może tworzyć jak najlepsze wirtualizowane środowiska GPU dla dostawców usług w chmurze.

- Architektura NVIDIA Ampere:

Bez względu na to, czy korzystasz z MIG do podziału GPU A100 na mniejsze instancje, czy z NVLink do łączenia wielu GPU w celu przyspieszenia obliczeń na dużą skalę, A100 jest w stanie obsłużyć różnorodne potrzeby dotyczące przyspieszenia, począwszy od najmniejszych zadań, aż po największe obciążenia wielonodowe. Wielofunkcyjność A100 pozwala menedżerom IT na maksymalne wykorzystanie każdego GPU w swoim centrum danych przez całą dobę. - Trzecia Generacja Tensor Cores:

Procesor NVIDIA A100 dostarcza wydajność głębokiego uczenia wynoszącą 312 teraflopów (TFLOPS). To aż 20-krotnie więcej operacji zmiennoprzecinkowych Tensorów na sekundę (FLOPS) w przypadku uczenia maszynowego i 20-krotnie więcej operacji na sekundę (TOPS) Tensorów w przypadku wnioskowania w porównaniu do procesorów NVIDIA Volta. - Nowa Generacja NVLink:

Technologia NVLink w procesorze A100 oferuje przepustowość 2-krotnie większą niż w poprzedniej generacji. W połączeniu z technologią NVIDIA NVSwitch™, można połączyć ze sobą nawet 16 procesorów A100 z przepustowością do 600 gigabajtów na sekundę (GB/s), co pozwala na osiągnięcie maksymalnej wydajności aplikacji na jednym serwerze. NVLink jest dostępny w procesorach A100 SXM na płytach serwerowych HGX A100 oraz w procesorach PCIe dzięki mostkowi NVLink do łączenia maksymalnie 2 procesorów. - Multi-Instance GPU (MIG):

Procesor A100 może zostać podzielony na aż siedem instancji GPU, które są w pełni izolowane na poziomie sprzętowym, posiadają własną pamięć o wysokiej przepustowości, pamięć podręczną i jednostki obliczeniowe. Technologia MIG daje programistom dostęp do przyspieszenia dla wszystkich ich aplikacji, a administratorzy IT mogą zapewnić odpowiednio dostosowane przyspieszenie GPU dla każdego zadania, optymalizując wykorzystanie i rozszerzając dostęp do każdego użytkownika i aplikacji. - Pamięć o Wysokiej Przepustowości (HBM2E):

Dzięki aż 80 gigabajtom pamięci HBM2e, A100 dostarcza najszybszą na świecie przepustowość pamięci GPU, wynoszącą ponad 2 TB/s, oraz wydajność w wykorzystywaniu pamięci RAM na poziomie 95%. A100 oferuje 1,7-krotnie wyższą przepustowość pamięci w porównaniu z poprzednią generacją. - Rzadka Struktura (Structural Sparsity):

Sieci neuronowe w dziedzinie AI posiadają miliony, a nawet miliardy parametrów. Nie wszystkie z tych parametrów są potrzebne do dokładnych prognoz, a niektóre można zamienić na zera, co pozwala na stworzenie "rzadkich" modeli bez kompromitowania dokładności. Jednostki Tensor Cores w A100 pozwalają na osiągnięcie nawet 2-krotnie wyższej wydajności w przypadku modeli rzadkich. Chociaż funkcja rzadkości przynosi największe korzyści w przypadku wnioskowania w AI, to również może poprawić wydajność treningu modelu.

NVIDIA A100 for PCIe NVIDIA A100 for HGX

| A100 80GB PCIe | A100 40GB SXM | A100 80GB SXM | |

|---|---|---|---|

| FP64 | 9.7 TFLOPS | ||

| FP64 Tensor Core | 19.5 TFLOPS | ||

| FP32 | 19.5 TFLOPS | ||

| Tensor Float 32 (TF32) | 156 TFLOPS | 312 TFLOPS* | ||

| BFLOAT16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | ||

| FP16 Tensor Core | 312 TFLOPS | 624 TFLOPS* | ||

| INT8 Tensor Core | 624 TOPS | 1248 TOPS* | ||

| GPU Memory | 80GB HBM2e | 40GB HBM2 | 80GB HBM2e |

| GPU Memory Bandwidth | 1,935GB/s | 1,555GB/s | 2,039GB/s |

| Max Thermal Design Power (TDP) | 300W | 400W | 400W |

| Multi-Instance GPU | Up to 7 MIGs @ 10GB | Up to 7 MIGs @ 5GB | Up to 7 MIGs @ 10GB |

| Form Factor | PCIe | SXM | |

| Interconnect | NVIDIA® NVLink® Bridge for 2 GPUs: 600GB/s ** PCIe Gen4: 64GB/s |

NVLink: 600GB/s PCIe Gen4: 64GB/s |

|

| Server Options | Partner and NVIDIA-Certified Systems™ with 1-8 GPUs | NVIDIA HGX™ A100-Partner and NVIDIA-Certified Systems with 4,8, or 16 GPUs NVIDIA DGX™ A100 with 8 GPUs |

|

Powiązane Strony:

- Serwery Gigabyte dedykowane dla NVidia L40S (Giga Computing)

- Serwery Supermicro dedykowane dla NVidia L40S

- NVidia L40S